MÜNCHEN (IT BOLTWISE) – KI sollte beim Kochen und auch sonst nur mit Vorsicht eingesetzt werden. Ein Nutzer von Google Gemini hätte sich und seine Familie beinahe vergiftet.

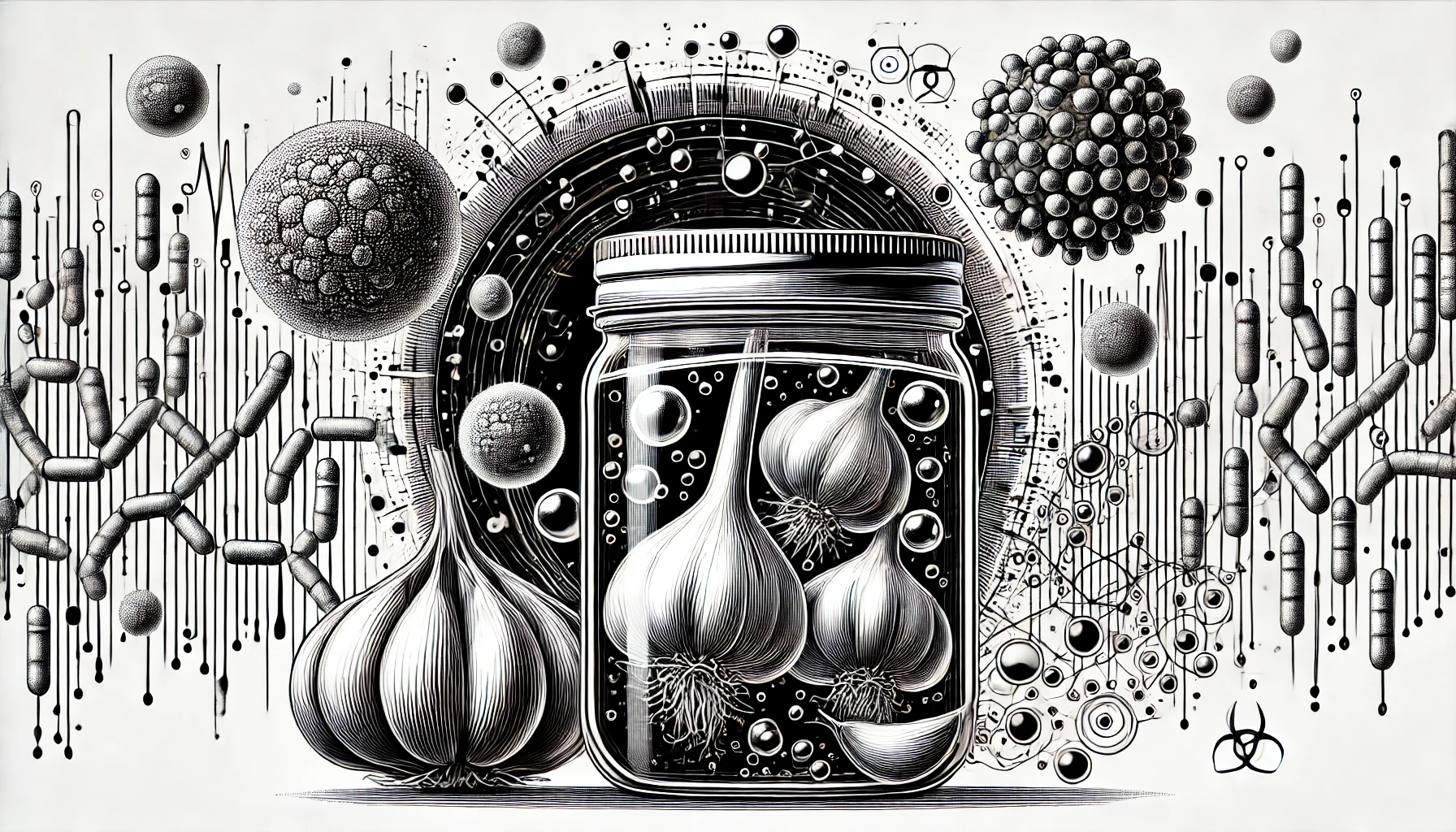

Auf Reddit ist eine Geschichte veröffentlicht worden, die die Risiken zeigt, wenn mit KI allzu sorglos umgegangen wird. In dem Beitrag wurde der Versuch eines Benutzers beschrieben, Knoblauch bei Raumtemperatur in Olivenöl einzulegen – eine Methode, die er aufgrund von der Anleitung von Google Gemini für harmlos hielt. Der Benutzer befolgte die Schritte genau: Knoblauchzehen schälen und leicht zerdrücken, dann in Olivenöl einlegen und bei Raumtemperatur ziehen lassen.

Der Infusionsprozess schien ohne Zwischenfälle zu verlaufen, bis der Benutzer ungewöhnliche Aktivitäten im Glas bemerkte. Nach einigen Tagen bildeten sich winzige Bläschen, die er zunächst für normal hielt. Am siebten Tag jedoch, als die Bläschen ausblieben und er immer noch Zweifel hatte, suchte er bei Google nach Antworten. Die Suche förderte eine beunruhigende Tatsache zutage: Die Bläschen waren ein Zeichen für das Wachstum des Bakteriums Clostridium botulinum. Die von diesem Bakterium gebildeten Nervengifte zählen zu den stärksten bekannten Giften und werden unter speziellen Umständen wie Sauerstoffabschluss gebildet.

Clostridium botulinum gedeiht besonders gut unter den anaeroben Bedingungen, die bei Ölinfusionen herrschen. Deshalb sollten Gefäße sterilisiert und die Knoblauchzehen bald wieder entnommen und das Glas im Kühlschrank gelagert werden. Noch sicherer ist es, die Zehen kurz anzubraten.

Golem.de probierte den gleichen Prompt, den der Nutzer bei Google Gemini eingegeben hatte, auch bei Claude.AI aus und erhielt den Warnhinweis auf potenzielles Bakterienwachstum und den Ratschlag, besonders sauber zu arbeiten. Auch bei ChatGPT gab es entsprechende Hinweise.

- Die besten Bücher rund um KI & Robotik!

- Die besten KI-News kostenlos per eMail erhalten!

- Zur Startseite von IT BOLTWISE® für aktuelle KI-News!

- IT BOLTWISE® kostenlos auf Patreon unterstützen!

- Aktuelle KI-Jobs auf StepStone finden und bewerben!

Stellenangebote

Expert*in für Erbenmanagement und KI Use Cases (Kundenservice)

Werkstudent KI und Digitalisierung (m/w/d)

Technischer Product Owner (m/w/d) Daten- und KI-Plattformen

Software Architect AI (all genders)

- Künstliche Intelligenz: Dem Menschen überlegen – wie KI uns rettet und bedroht | Der Neurowissenschaftler, Psychiater und SPIEGEL-Bestsellerautor von »Digitale Demenz«

Du hast einen wertvollen Beitrag oder Kommentar zum Artikel "Fehlerhafte Kochanweisungen von Googles Künstlicher Intelligenz: Googles Gemini-KI hätte beinahe Anwender vergiftet" für unsere Leser?

#Sophos

#Sophos

Es werden alle Kommentare moderiert!

Für eine offene Diskussion behalten wir uns vor, jeden Kommentar zu löschen, der nicht direkt auf das Thema abzielt oder nur den Zweck hat, Leser oder Autoren herabzuwürdigen.

Wir möchten, dass respektvoll miteinander kommuniziert wird, so als ob die Diskussion mit real anwesenden Personen geführt wird. Dies machen wir für den Großteil unserer Leser, der sachlich und konstruktiv über ein Thema sprechen möchte.

Du willst nichts verpassen?

Du möchtest über ähnliche News und Beiträge wie "Fehlerhafte Kochanweisungen von Googles Künstlicher Intelligenz: Googles Gemini-KI hätte beinahe Anwender vergiftet" informiert werden? Neben der E-Mail-Benachrichtigung habt ihr auch die Möglichkeit, den Feed dieses Beitrags zu abonnieren. Wer natürlich alles lesen möchte, der sollte den RSS-Hauptfeed oder IT BOLTWISE® bei Google News wie auch bei Bing News abonnieren.

Nutze die Google-Suchmaschine für eine weitere Themenrecherche: »Fehlerhafte Kochanweisungen von Googles Künstlicher Intelligenz: Googles Gemini-KI hätte beinahe Anwender vergiftet« bei Google Deutschland suchen, bei Bing oder Google News!