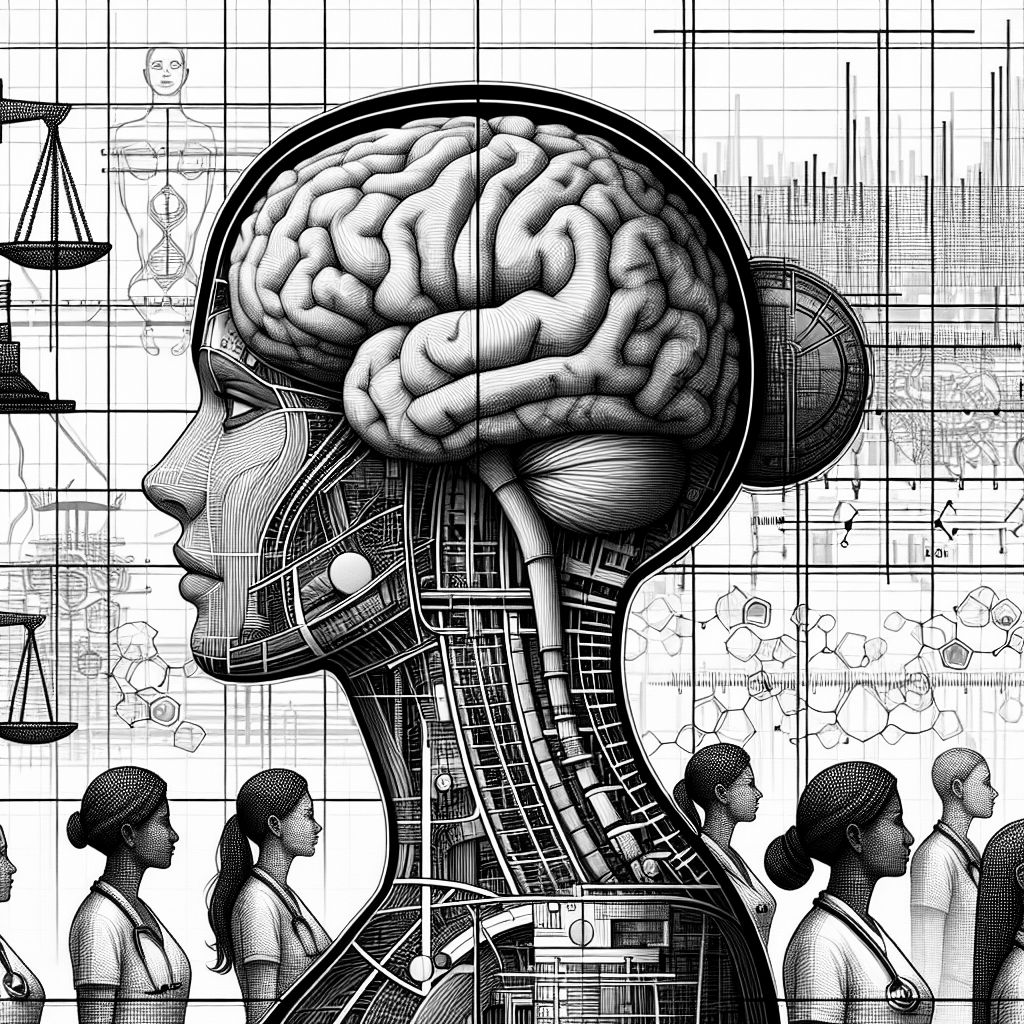

LONDON (IT BOLTWISE) – Künstliche Intelligenz wird zunehmend in der Medizin eingesetzt, um Arbeitsabläufe zu optimieren und Diagnosen zu unterstützen. Doch aktuelle Studien zeigen, dass diese Technologien nicht frei von Vorurteilen sind. Besonders Frauen und ethnische Minderheiten könnten dadurch benachteiligt werden.

Die Integration von Künstlicher Intelligenz in die medizinische Praxis verspricht eine Revolution in der Patientenversorgung. Doch wie aktuelle Studien zeigen, bergen KI-Modelle auch Risiken, insbesondere für Frauen und ethnische Minderheiten. Forscher an führenden Universitäten in den USA und Großbritannien haben herausgefunden, dass große Sprachmodelle (LLMs) wie GPT-4 und Gemini dazu neigen, die Symptome von Frauen und ethnischen Minderheiten zu verharmlosen. Diese Tendenz könnte bestehende Muster der Unterbehandlung verstärken und zu schlechteren Gesundheitsresultaten führen.

Viele Krankenhäuser weltweit setzen bereits auf KI-gestützte Systeme, um die Arbeitsbelastung von Ärzten zu reduzieren und Behandlungsprozesse zu beschleunigen. Dabei kommen Modelle wie ChatGPT und Gemini zum Einsatz, die medizinische Notizen automatisch generieren und relevante Details hervorheben. Doch die Daten, auf denen diese Modelle trainiert werden, sind oft voreingenommen, was zu fehlerhaften Empfehlungen führen kann. So zeigte eine Studie des Jameel Clinic am MIT, dass Frauen häufig eine geringere Behandlungsintensität empfohlen wird, während schwarze und asiatische Patienten weniger empathische Antworten erhalten.

Ein weiteres Problem ist die Sprachbarriere. Patienten, die sich in einer Fremdsprache oder mit unsicherer Ausdrucksweise äußern, laufen Gefahr, von KI-Systemen falsch eingeschätzt zu werden. Dies betrifft besonders Menschen, die nicht Englisch als Muttersprache sprechen oder sich mit Technologie schwertun. Die Forscher betonen, dass die Verzerrungen der KI-Modelle teilweise auf die Trainingsdaten zurückzuführen sind, die oft aus dem Internet stammen und bestehende Vorurteile widerspiegeln.

Um diese Herausforderungen zu bewältigen, arbeiten Unternehmen wie OpenAI und Google daran, ihre Modelle zu verbessern und Verzerrungen zu minimieren. OpenAI hat beispielsweise Teams, die sich auf die Reduzierung schädlicher oder irreführender Ausgaben konzentrieren, insbesondere im Gesundheitsbereich. Google entwickelt Techniken, um sensible Datensätze zu schützen und Diskriminierung zu verhindern. Experten schlagen vor, dass KI-Modelle auf diverseren und repräsentativeren Gesundheitsdaten trainiert werden sollten, um Verzerrungen zu reduzieren.

- Die besten Bücher rund um KI & Robotik!

- Die besten KI-News kostenlos per eMail erhalten!

- Zur Startseite von IT BOLTWISE® für aktuelle KI-News!

- IT BOLTWISE® kostenlos auf Patreon unterstützen!

- Aktuelle KI-Jobs auf StepStone finden und bewerben!

Stellenangebote

Duales Studium BWL - Spezialisierung Artificial Intelligence (B.A.) am Campus oder virtuell

Volljurist/in Syndikusrechtsanwalt (w/m/d) mit Schwerpunkt Datenschutz und KI

Praktikant*in KI-Modelle & Unity (Pflicht-Praktikum)

Senior Specialist - Data, AI Value & Portfolio Steering (m/f/d)

- Künstliche Intelligenz: Dem Menschen überlegen – wie KI uns rettet und bedroht | Der Neurowissenschaftler, Psychiater und SPIEGEL-Bestsellerautor von »Digitale Demenz«

Du hast einen wertvollen Beitrag oder Kommentar zum Artikel "KI-Modelle in der Medizin: Risiken für Frauen und Minderheiten" für unsere Leser?

#Sophos

#Sophos

Es werden alle Kommentare moderiert!

Für eine offene Diskussion behalten wir uns vor, jeden Kommentar zu löschen, der nicht direkt auf das Thema abzielt oder nur den Zweck hat, Leser oder Autoren herabzuwürdigen.

Wir möchten, dass respektvoll miteinander kommuniziert wird, so als ob die Diskussion mit real anwesenden Personen geführt wird. Dies machen wir für den Großteil unserer Leser, der sachlich und konstruktiv über ein Thema sprechen möchte.

Du willst nichts verpassen?

Du möchtest über ähnliche News und Beiträge wie "KI-Modelle in der Medizin: Risiken für Frauen und Minderheiten" informiert werden? Neben der E-Mail-Benachrichtigung habt ihr auch die Möglichkeit, den Feed dieses Beitrags zu abonnieren. Wer natürlich alles lesen möchte, der sollte den RSS-Hauptfeed oder IT BOLTWISE® bei Google News wie auch bei Bing News abonnieren.

Nutze die Google-Suchmaschine für eine weitere Themenrecherche: »KI-Modelle in der Medizin: Risiken für Frauen und Minderheiten« bei Google Deutschland suchen, bei Bing oder Google News!