LONDON (IT BOLTWISE) – Die Transformer-Architektur hat die Sprachverarbeitung revolutioniert und bietet eine effizientere und skalierbarere Lösung als frühere Modelle. Mit Self-Attention als Schlüsselmechanismus ermöglicht sie eine parallele Verarbeitung und eine umfassende Kontextanalyse, was sie zur Grundlage moderner KI-Systeme macht.

Die Einführung der Transformer-Architektur hat die Welt der Sprachverarbeitung grundlegend verändert. Während Recurrent Neural Networks (RNNs) lange als Standard galten, stießen sie bei der Verarbeitung langer Texte und komplexer Abhängigkeiten an ihre Grenzen. Transformer-Modelle hingegen, wie GPT und BERT, haben sich als leistungsfähiger und effizienter erwiesen, indem sie alle Teile eines Textes gleichzeitig betrachten können.

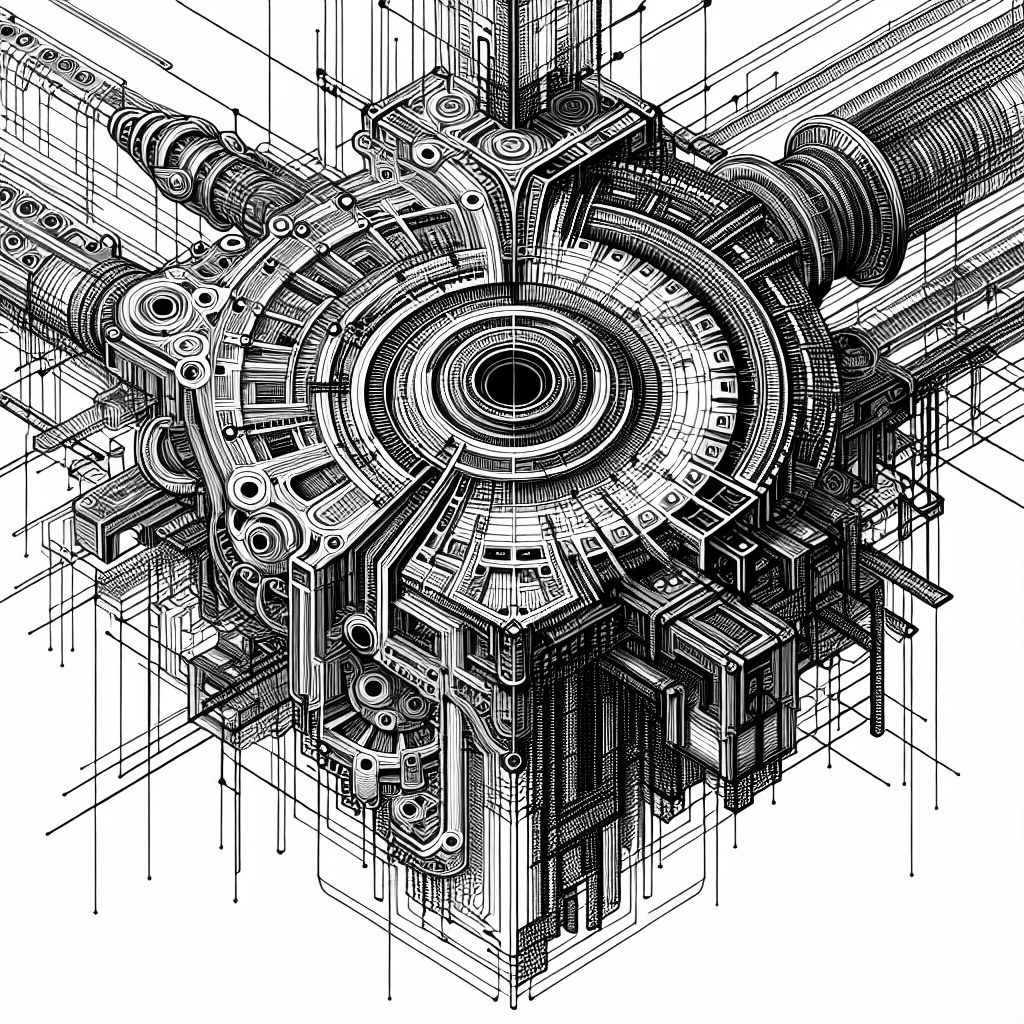

Der entscheidende Mechanismus hinter dieser Architektur ist die Self-Attention. Dieser ermöglicht es, den Kontext über beliebige Distanzen hinweg zu berücksichtigen und Eingaben parallel zu verarbeiten. Dadurch wird nicht nur die Effizienz gesteigert, sondern auch die Flexibilität, was Transformer-Modelle zur dominierenden Grundlage für viele KI-Systeme macht.

Ein weiterer Vorteil der Transformer-Modelle ist ihre Fähigkeit zur Skalierung. Moderne Modelle enthalten Milliarden von Parametern und können auf riesigen Datenmengen trainiert werden, was frühere Verfahren überfordert hätte. Dies hat den Siegeszug der Transformer entscheidend geprägt und sie zu einem universellen Baukasten moderner KI gemacht.

Die Self-Attention-Technologie bewertet für jedes Element in einer Eingabesequenz, wie stark es auf andere Elemente achten sollte. Dies geschieht über Query-, Key- und Value-Vektoren, die aus den Eingabedaten erzeugt werden. Die resultierenden Gewichte fließen dann in die nächste Repräsentation ein, was eine flexible und kontextbezogene Verarbeitung ermöglicht.

Zusätzlich benötigen Transformer-Modelle eine positionale Kodierung, um die Reihenfolge der Eingaben zu berücksichtigen. Diese sorgt dafür, dass die relative und absolute Position von Wörtern im Satz erhalten bleibt, was für das Verständnis der Satzstruktur unerlässlich ist.

Insgesamt haben Transformer-Modelle die Sprachverarbeitung revolutioniert, indem sie eine kontextsensitive und globale Verarbeitung ermöglichen. Sie sind hochgradig parallelisierbar, modular und flexibel anpassbar, was sie nicht nur für Sprache, sondern auch für Bilder, Videos und andere Datenformate geeignet macht.

- Die besten Bücher rund um KI & Robotik!

- Die besten KI-News kostenlos per eMail erhalten!

- Zur Startseite von IT BOLTWISE® für aktuelle KI-News!

- IT BOLTWISE® kostenlos auf Patreon unterstützen!

- Aktuelle KI-Jobs auf StepStone finden und bewerben!

Stellenangebote

Bauprojektleiter Technische Gebäudeausrüstung Elektrotechnik für KI- Rechenzentrumprojekte (m/w/d)

Bauprojektmanager/Projektleiter als Bauherrenvertretung für KI-Rechenzentrumprojekte (m/w/d) HN o. B

Duales Studium Data Science und KI - Smart Operations Management 2026

KI-Experte* Schwerpunkt Interner Chatbot und Business Enablement

- Künstliche Intelligenz: Dem Menschen überlegen – wie KI uns rettet und bedroht | Der Neurowissenschaftler, Psychiater und SPIEGEL-Bestsellerautor von »Digitale Demenz«

Du hast einen wertvollen Beitrag oder Kommentar zum Artikel "Transformer-Architektur: Der Wandel in der Sprachverarbeitung" für unsere Leser?

#Sophos

#Sophos

Es werden alle Kommentare moderiert!

Für eine offene Diskussion behalten wir uns vor, jeden Kommentar zu löschen, der nicht direkt auf das Thema abzielt oder nur den Zweck hat, Leser oder Autoren herabzuwürdigen.

Wir möchten, dass respektvoll miteinander kommuniziert wird, so als ob die Diskussion mit real anwesenden Personen geführt wird. Dies machen wir für den Großteil unserer Leser, der sachlich und konstruktiv über ein Thema sprechen möchte.

Du willst nichts verpassen?

Du möchtest über ähnliche News und Beiträge wie "Transformer-Architektur: Der Wandel in der Sprachverarbeitung" informiert werden? Neben der E-Mail-Benachrichtigung habt ihr auch die Möglichkeit, den Feed dieses Beitrags zu abonnieren. Wer natürlich alles lesen möchte, der sollte den RSS-Hauptfeed oder IT BOLTWISE® bei Google News wie auch bei Bing News abonnieren.

Nutze die Google-Suchmaschine für eine weitere Themenrecherche: »Transformer-Architektur: Der Wandel in der Sprachverarbeitung« bei Google Deutschland suchen, bei Bing oder Google News!